La inteligencia artificial es ahora parte de la vida cotidiana. Está en nuestros teléfonos, escuelas y hogares. Para los jóvenes, la IA está dando forma a la forma en que aprenden, se conectan y se expresan. Pero también plantea preocupaciones reales sobre la privacidad, la equidad y el control.

Los sistemas de IA suelen prometer personalización y comodidad. Pero detrás de escena, recopilan grandes cantidades de datos personales, predicen e influyen en el comportamiento, sin reglas ni consentimiento claros.

Esto preocupa especialmente a los jóvenes, que a menudo quedan fuera de las conversaciones sobre cómo se construyen y gestionan los sistemas de inteligencia artificial.

Una guía del autor sobre cómo proteger la privacidad de los jóvenes en un mundo de inteligencia artificial. Preocupaciones de privacidad

Mi equipo de investigación realizó una encuesta nacional y escuchó a jóvenes de 16 a 19 años que usan la IA todos los días, en las redes sociales, en las aulas y en juegos en línea.

Nos dijeron que quieren los beneficios de la inteligencia artificial, pero no a costa de su privacidad. Si bien aprecian el contenido personalizado y las recomendaciones inteligentes, se sienten incómodos con lo que sucede con sus datos.

Muchos han expresado preocupación sobre quién es el propietario de su información, cómo se utiliza y si algún día podrán recuperarla. Se sienten frustrados por las largas políticas de privacidad, las configuraciones ocultas y la sensación de que hay que ser un experto técnico sólo para protegerse.

Como dijo un participante:

“Lo que más me preocupa es qué datos se toman y cómo se utilizan. A menudo no estamos claramente informados”.

Se resisten a compartir sus datos

Los jóvenes eran el grupo más incómodo a la hora de compartir datos personales con inteligencia artificial. Incluso cuando obtuvieron algo a cambio, como beneficios o ajustes, no creían lo que sucedería después. Muchos se preocupan por ser observados, seguidos o categorizados de maneras que no pueden ver.

Esto va más allá de los riesgos técnicos. Se trata de cómo se siente ser analizado y predicho constantemente por sistemas que no puedes cuestionar ni comprender.

La IA no sólo recopila datos, sino que también hace inferencias, da forma a las experiencias en línea e influye en las elecciones. Puede parecer una manipulación.

Padres y profesores están preocupados

Los adultos (educadores y padres) en nuestro estudio compartieron preocupaciones similares. Quieren mejores protecciones y reglas más estrictas.

Pero muchos admitieron que están luchando por mantenerse al día con la velocidad de la IA. A menudo no se sienten seguros ayudando a los jóvenes a tomar decisiones inteligentes sobre los datos y la privacidad.

Algunos lo vieron como una brecha en la educación digital. Otros señalaron la necesidad de explicaciones en lenguaje sencillo y una mayor transparencia por parte de las empresas de tecnología que construyen e implementan sistemas de inteligencia artificial.

Los padres y educadores luchan con el ritmo del desarrollo de la inteligencia artificial. (Getty Images/Unsplash) Los profesionales se centran en las herramientas, no en las personas

El estudio encontró que los profesionales de la IA abordan estos desafíos de manera diferente. Piensan en la privacidad en términos técnicos como cifrado, minimización de datos y cumplimiento.

Si bien estos son importantes, no siempre son coherentes con lo que les importa a los jóvenes y a los educadores: la confianza, el control y el derecho a comprender lo que está sucediendo.

Las empresas suelen ver la privacidad como una compensación por la innovación. Valoran la eficiencia y el rendimiento y tienden a confiar en las soluciones técnicas por encima de las aportaciones de los usuarios. Esto puede dejar de lado las principales preocupaciones de las personas más vulnerables, especialmente los usuarios jóvenes.

El poder y el control están en otra parte

Los profesionales, padres y educadores de la IA influyen en cómo se utiliza la IA. Pero las decisiones más importantes ocurren en otros lugares. Poderosas empresas tecnológicas diseñan la mayoría de las plataformas digitales y deciden qué datos se recopilan, cómo funcionan los sistemas y qué opciones ven los usuarios.

Incluso cuando los profesionales abogan por prácticas más seguras, están trabajando dentro de sistemas que no construyeron. Las leyes de privacidad débiles y la aplicación limitada significan que el control sobre los datos y el diseño permanece en manos de unas pocas empresas.

Esto dificulta aún más la transparencia y la responsabilización de las plataformas.

Las empresas tecnológicas tienen todo el control en lo que respecta a la IA. (Foto AP) ¿Qué falta? Entendimiento común

En este momento, los jóvenes, los padres, los educadores y las empresas de tecnología no están en la misma página. Los jóvenes quieren control, los padres quieren protección y los profesionales quieren escalabilidad.

Estos objetivos a menudo entran en conflicto y, sin una visión compartida, las políticas de privacidad son inconsistentes, difíciles de hacer cumplir o simplemente se ignoran.

Nuestra investigación muestra que la gobernanza ética de la inteligencia artificial no puede ser resuelta por un solo grupo. Necesitamos reunir a jóvenes, familias, educadores y expertos para dar forma al futuro de la inteligencia artificial.

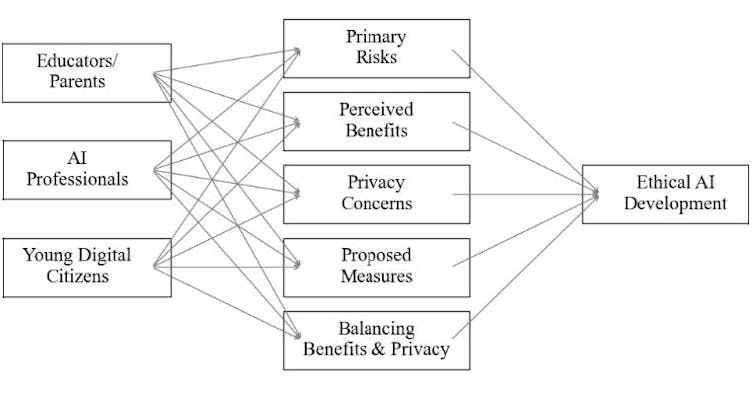

Modelo PEA-AI

1. Control versus confianza: los jóvenes quieren autonomía. Los desarrolladores quieren confiabilidad. Necesitamos sistemas que admitan ambos.

2. Transparencia versus percepción: Lo que los expertos consideran “claro” suele resultar confuso para los usuarios.

3. Supervisión de los padres versus voz de los jóvenes: las políticas deben equilibrar la protección y el respeto por la agencia de los jóvenes.

4. Brechas en educación versus concientización: No podemos esperar que los jóvenes tomen decisiones informadas sin mejores herramientas y apoyo.

El diagrama conceptual muestra cómo actores clave como los jóvenes, los padres y los profesionales de la IA dan forma a los cinco constructos clave que influyen en el desarrollo ético de la IA. (Ajai Shrestha/Proyecto OPC) ¿Qué se puede hacer?

Nuestra investigación apunta a seis pasos prácticos:

1. Simplificar el consentimiento. Utilice formas breves y visuales en un lenguaje sencillo. Haga que los jóvenes actualicen su configuración periódicamente.

2. Diseño para la privacidad. Minimizar la recopilación de datos. Cree paneles que muestren a los usuarios lo que se está almacenando.

3. Explicar los sistemas. Proporcionar explicaciones claras y no técnicas sobre cómo funciona la IA, especialmente cuando se utiliza en las escuelas.

4. Hacer responsables a los sistemas. Ejecute auditorías, permita comentarios y cree formas para que los usuarios informen daños.

5. Aprenda sobre privacidad. Llevar la alfabetización en IA a las aulas. Formar a los profesores e involucrar a los padres.

6. Compartir el poder. Involucrar a los jóvenes en las decisiones de política tecnológica. Construya sistemas con ellos, no sólo para ellos.

La IA puede ser una herramienta poderosa para el aprendizaje y la conexión, pero debe construirse con cuidado. En este momento, nuestra investigación sugiere que los jóvenes no se sienten en control de cómo la IA los ve, utiliza sus datos o da forma a su mundo.

La IA ética comienza con escuchar. Si queremos que los sistemas digitales sean justos, seguros y confiables, debemos darles a los jóvenes un asiento en la mesa y tratar su voz como algo esencial, no opcional.

Descubre más desde USA Today

Suscríbete y recibe las últimas entradas en tu correo electrónico.